Perceptron-algoritmen

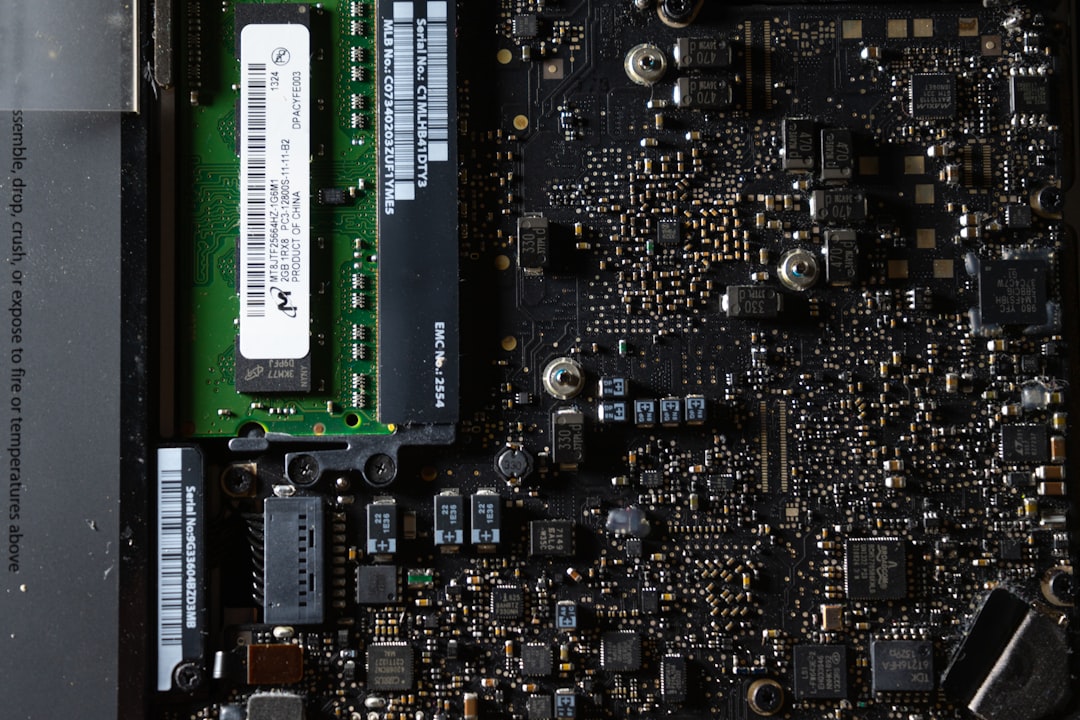

Frank Rosenblatt udviklede perceptron, den første praktiske model der kunne lære simple mønstre fra data. Mark I Perceptron var en fysisk maskine med fotoceller, og den gjorde idéen om læring i maskiner konkret.

I 1958 byggede Frank Rosenblatt Mark I Perceptron, en fysisk maskine der kunne genkende simple mønstre. Det var et tidligt eksempel på, at læring kan beskrives matematisk og implementeres i hardware. Ideen gjorde stærkt indtryk, fordi den pegede på en maskine der kunne forbedre sig gennem erfaring.

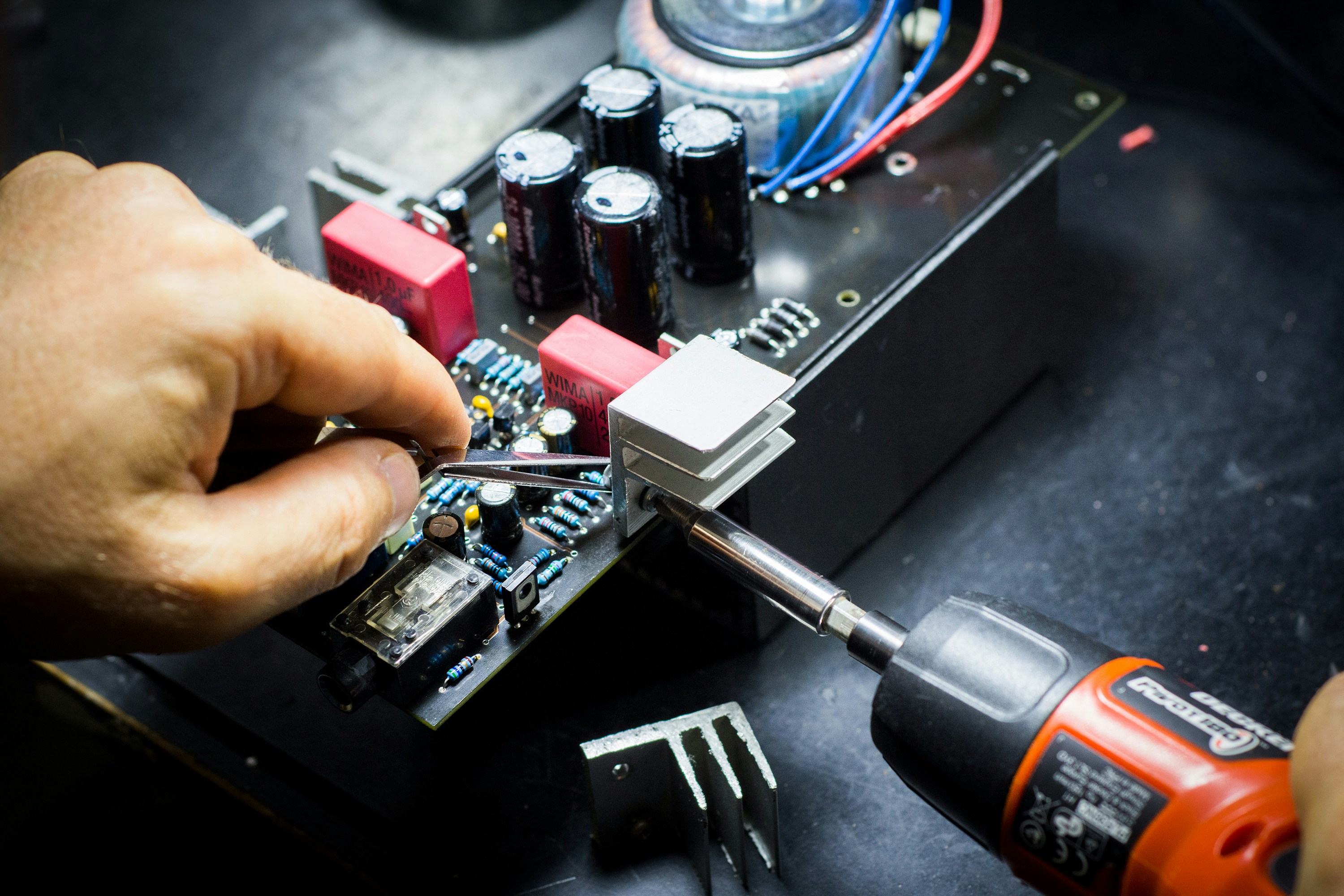

Hvordan læringen virkede

Perceptron justerede sine vægte, når den lavede fejl. Den sammenlignede forventet og faktisk resultat og flyttede vægtene i små trin. Over tid gav gentagne eksempler en bedre klassifikation. Mekanismen var enkel, men den viste, at læring kan automatiseres uden at programmere hver regel.

Begrænsninger og backlash

Perceptron kunne kun løse meget simple opgaver. I 1969 viste Minsky og Papert matematiske begrænsninger i single layer netværk, og det dæmpede optimismen. Resultatet var en periode med lavere investeringer i neurale netværk. Kritikken var vigtig, fordi den gjorde det klart, at der skulle mere kompleksitet til.

Arven i dag

Selv med begrænsninger blev perceptron et symbol på lærende systemer. Nutidens deep learning bygger stadig på samme grundidé, nemlig at vægte justeres ud fra fejl. Forskellen er flere lag, mere data og langt større regnekraft. Perceptron viste retningen, selv om teknologien dengang var for tidlig.

Impact og Betydning

Perceptron gjorde det plausibelt, at maskiner kunne lære af data i stedet for at blive håndprogrammeret. Det ændrede forskningssporet og blev et tidligt skridt mod moderne machine learning. Erfaringerne fra både succes og begrænsninger gav vigtig læring, som senere blev brugt i dybere netværk.